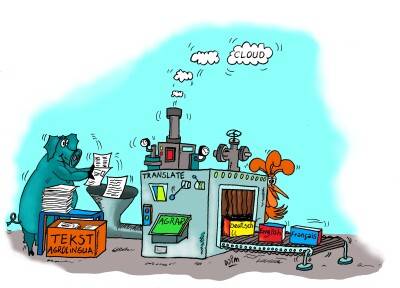

Van eenvoudig programma tot zelflerende technologie: hoe zijn machinevertalingen in de loop van de tijd veranderd?

Google Translate, DeepL, Reverso Context: de kans is groot dat u een of meerdere van deze vertaaltools wel eens heeft gebruikt. Maar waar komen machinevertalingen eigenlijk vandaan en hoe zijn ze in de loop van de tijd veranderd?

Geschiedenis

Voor de oorsprong van machinevertalingen moeten we terug naar de jaren 50 van de vorige eeuw. Warren Weaver, een Amerikaans wiskundige en communicatiewetenschapper, wordt gezien als een van de pioniers op het gebied van machinevertalingen. In 1949 leverde hij een publicatie met de titel ‘’Translation’’. Hierin beschreef hij dat de essentie van een taal veel verder gaat dan het woordniveau. Zo vond hij bijvoorbeeld dat ook de structuur van zinnen een belangrijke rol speelt bij het vertalen van teksten. Vertalen was volgens Weaver dus een complexe taak waar een stuk meer bij komt kijken dan een tekst simpelweg woord voor woord omzetten. Zijn publicatie inspireerde onderzoekers om te gaan experimenteren met machinevertalingen.

Zo ontstond in 1954 het Georgetown-IBM-experiment. Het doel van deze proef was om de mogelijkheden van machinevertalingen te demonstreren door Russische zinnen naar het Engels te vertalen met behulp van een computer. Het experiment was echter niet heel succesvol. De computer was namelijk niet in staat om de nuances van de talen en de context van de teksten te begrijpen, waardoor de vertaling kwalitatief niet goed was. Dit experiment liet de uitdagingen van machinevertalingen en de complexiteit van taalbegrip zien, vooral bij talen met verschillende grammaticale structuren zoals het Russisch en het Engels.

Ondanks de tegenvallende resultaten vormde dit experiment wél de basis voor verder onderzoek en ontwikkeling. Het inspireerde onderzoekers om te blijven werken aan verbeterde machinevertalingen, wat uiteindelijk heeft geleid tot de geavanceerde vertaaltools die we tegenwoordig kunnen gebruiken.

Rule-based machine translation

De eerste machinevertalingen waren dus allesbehalve nauwkeurig. De oorzaak hiervan was dat de systemen van toen gebaseerd waren op eenvoudige grammaticaregels en woordenboekdefinities, ook wel “rule-based machine translation (RBMT)” genoemd. Het Georgetown-IBM-experiment was één van de eerste pogingen om een RBMT-systeem te ontwikkelen. Met RBMT werden teksten dus bijna letterlijk woord voor woord vertaald. Dit leverde enorm onnatuurlijke vertalingen op die soms zelfs bijna onbegrijpelijk waren.

Statistische vertaalmodellen

In de jaren 90 kwamen er statistische vertaalmodellen, die een revolutie op het gebied van machinevertalingen teweegbrachten. De manier waarop deze modellen werken, is gebaseerd op percentages/kansberekening: er worden grote hoeveelheden tweetalige teksten geanalyseerd om patronen en correlaties tussen woorden en zinsstructuren te vinden. Op basis van deze statistieken konden de statistische vertaalmodellen betere vertalingen produceren dan RMBT-systemen. Natuurlijk waren ook deze vertalingen verre van perfect, maar de kwaliteit was wel aanzienlijk verbeterd ten opzichte van de veel te letterlijke vertalingen van de RBMT-systemen.

Neurale netwerken

Hoewel statistische vertaalmodellen al een stuk betere kwaliteit leverden, kwam de echte doorbraak met de opkomst van neurale netwerken. Deze worden getraind op basis van grote hoeveelheden tekst om zo vertaalmodellen te ontwikkelen die niet alleen de betekenis van zinnen en woorden beter begrijpen, maar ook de context. Deze methode wordt neurale machinevertaling (NMT) genoemd. Omdat deze modellen o.a. beter zijn in het begrijpen van context, zijn de traditionele statistische vertaalmodellen inmiddels grotendeels vervangen. Twee bekende voorbeelden van vertaalmachines die gebruikmaken van neurale netwerken zijn Google Translate en DeepL.

Deep learning

Deep learning is een vorm van machine learning die gebruikmaakt van kunstmatige neurale netwerken die uit meerdere lagen bestaan (vandaar "deep"). Om een tekst te kunnen vertalen, heeft het model een grote hoeveelheid data uit beide talen nodig, zodat het systeem leert hoe zinnen overeenkomen. De vertaalmodellen worden ook steeds geoptimaliseerd. Hierdoor leert het systeem dus van zijn fouten. Hoe meer teksten er dus met zo’n systeem worden vertaald, hoe nauwkeuriger het systeem zal worden.

Toekomstperspectief

Deep Learning heeft een cruciale rol gespeeld in de verdere verbetering van machinevertalingen. De toekomstverwachting is dan ook dat ze nauwkeuriger zullen worden en ook beter in staat zullen zijn om de subtiele nuances en contexten van talen te begrijpen. Hoewel de vooruitgang dus enorm is, zijn machinevertalingen nog steeds verre van perfect. Zo kan er in een brontekst bijvoorbeeld staan dat je iets niet moet doen en staat er vervolgens in de vertaling dat je het juist wél moet doen. Dat kan natuurlijk verregaande gevolgen hebben, vooral bij juridische teksten. Maar ook culturele nuances, idiomatische uitdrukkingen en vakspecifieke terminologie worden vaak verkeerd vertaald.

De kans dat een vertaaltool zoals DeepL agrarische vakterminologie correct vertaalt, is dus niet heel groot. Zeker voor vakspecifieke vertalingen is het dus altijd beter om een menselijke vertaler in te schakelen. De vertalers van AgroLingua beschikken niet alleen over taalkundige kennis, maar zijn ook allemaal gespecialiseerd in de agrarische sector. Hierdoor zijn wij in staat om uw teksten op een nauwkeurige manier te vertalen en brengen we de juiste boodschap over.

Terug naar blogs

.png)